Por Que Construir Multi-Agent LLMs Pode Ser Uma Cilada (E Como Focar no Essencial Para Agentes de IA)

Você já quis construir aquela ‘equipe dos sonhos’ de agentes inteligentes para resolver tudo em paralelo? Eu já tentei. Na primeira vez, confiei que subagentes trariam robustez ao meu sistema — imaginei uma orquestra harmônica de IA. Só que na prática, caiu tudo como um dominó. Compartilho aqui minhas cicatrizes e aprendizados: frameworks de multi-agentes parecem promissores, mas, na real, são uma aventura cheia de armadilhas (e, acredite, algumas surpresas até engraçadas).

O Mito dos Multi-Agent LLMs: Por Que a Promessa Raramente se Cumpre

Quando comecei a explorar Multi-Agent LLMs, confesso que me deixei levar pelo entusiasmo. A ideia de usar vários agentes paralelos parecia a solução perfeita para aumentar a eficiência dos sistemas de IA. Frameworks como OpenAI Swarm e Agno prometiam uma estrutura robusta para criar Sistemas Multi-Agentes resilientes, capazes de dividir tarefas complexas e acelerar resultados. Mas, na prática, a realidade é bem diferente.

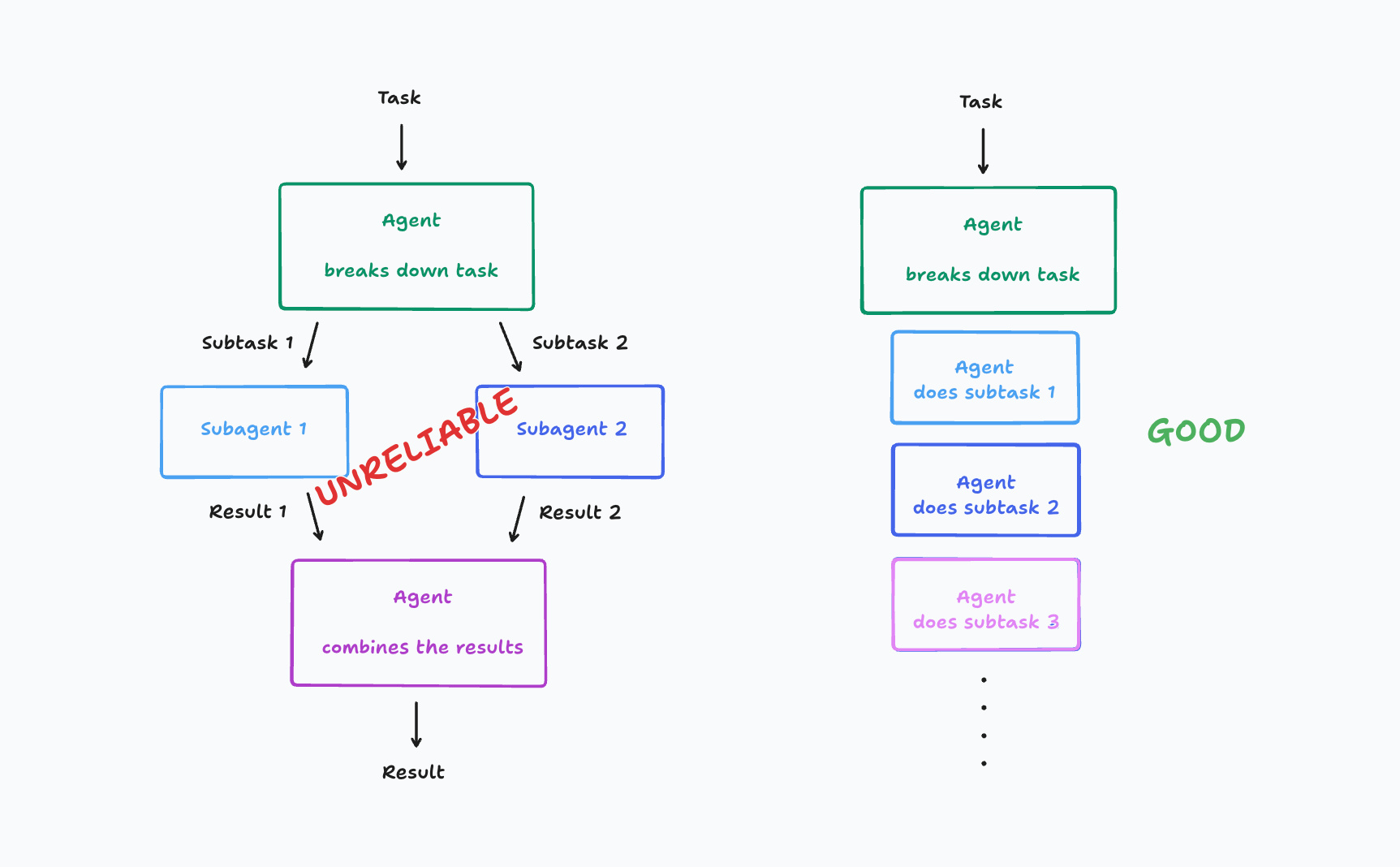

O grande problema está na fragmentação do contexto . Quando múltiplos agentes trabalham em paralelo, cada um recebe apenas uma parte da informação. Isso pode parecer suficiente em tarefas simples, mas, em situações reais, onde as demandas mudam a cada interação, essa divisão gera caos. Já vi agentes tomando decisões conflitantes, entregando resultados incoerentes e, no fim, tornando o sistema difícil de manter. Não é à toa que, em 2025, ainda vemos tantos relatos de sistemas multi-agentes fáceis de quebrar.

Frameworks de LLM Frameworks como o OpenAI Swarm e o Agno realmente facilitam o desenvolvimento, mas não resolvem o desafio central: como garantir que todos os agentes compartilhem o contexto de forma eficaz? Estudos recentes mostram que, mesmo com avanços em Colaboração de Agentes , o baixo compartilhamento de contexto continua sendo um gargalo. Tarefas reais são imprevisíveis, exigindo flexibilidade e um fluxo contínuo de informações entre agentes. E isso, infelizmente, ainda não é trivial de implementar.

Para ilustrar, basta olhar para a evolução dos frameworks. Em 2013, o Facebook lançou o React, revolucionando o desenvolvimento web ao propor modularidade e reatividade. Já em 2024, modelos de edição de código baseados em subagentes eram notoriamente falhos. Em 2025, o Claude Code utiliza subagentes, mas nunca em paralelo para tarefas de codificação — justamente para evitar conflitos de contexto. Grandes modelos de linguagem continuam enfrentando limitações de contexto, especialmente quando ultrapassam 8K-32K tokens.

“A promessa de colaboração paralela em multi-agentes é irresistível, mas a complexidade oculta faz o sistema desmoronar.” — Walden, Cognition

Olhando para esses exemplos, fica claro: frameworks de Sistemas Multi-Agentes parecem promissores, mas a fragmentação do contexto resulta em decisões conflitantes e pouca confiabilidade. Por isso, muitos modelos de ponta, como o Claude Code, preferem sequências lineares, onde o contexto é preservado e as decisões são mais consistentes.

A Pedra Fundamental: Engenharia de Contexto em Agentes de IA

Quando comecei a construir agentes de IA, logo percebi que a Engenharia de Contexto em IA é o verdadeiro segredo por trás de sistemas realmente robustos. Muita gente ainda foca apenas em “prompt engineering”, tentando encontrar a frase perfeita para cada tarefa. Mas, na prática, o que faz diferença é como estruturamos o fluxo de informação entre os agentes e como garantimos que cada decisão seja tomada com base em um contexto relevante e acumulado.

Imagine um cenário comum: você tem um agente principal que divide uma tarefa em várias partes e delega para subagentes. Parece eficiente, certo? Só que, na maioria das vezes, esses subagentes acabam tomando decisões baseadas em contextos parciais ou desatualizados. Já vi isso acontecer diversas vezes: dez subagentes trabalhando em paralelo, mas nenhum deles realmente “sabendo” o que os outros estão fazendo. O resultado? Decisões conflitantes, ambiguidade e, muitas vezes, retrabalho.

Minha experiência mostra que um agente com contexto linear — ou seja, aquele que mantém uma linha contínua de decisões e histórico — é muito mais confiável do que um exército de subagentes tentando conversar sozinhos. Isso porque, ao acumular contexto, o agente consegue tomar decisões coerentes e evitar interpretações ambíguas. E é aí que entra a Engenharia de Contexto: ela vai além da simples otimização de prompts e se concentra em criar mecanismos para que o agente sempre tenha acesso ao que realmente importa.

Claro, existe um desafio técnico importante: os context windows dos Grandes Modelos de Linguagem (LLMs) são limitados, geralmente entre 8K e 32K tokens. Para tarefas longas, inevitavelmente o contexto vai “estourar” esse limite. O que fazer? A resposta está na compressão inteligente do histórico. Em vez de tentar passar tudo para todos os subagentes, uso modelos dedicados para resumir e condensar o histórico em pontos-chave. Isso não só melhora a performance dos agentes, como também permite que eles fiquem ativos por mais de 24 horas sem perder relevância — algo essencial em aplicações de produção.

“Engenharia de contexto é o superpoder escondido de sistemas de agentes confiáveis.” — Walden, Cognition

Hoje, frameworks e AI Development Tools mais modernos já começam a incorporar soluções baseadas em compressão de histórico, pois a customização de agentes depende diretamente do domínio do contexto em execução. Estudos indicam que, para sistemas realmente robustos, a engenharia de contexto é mais importante do que qualquer arquitetura multi-agente paralela. Afinal, criar agentes que compartilham e mantêm histórico de decisões gera sistemas consistentes, mesmo que isso exija modelos dedicados ou ajustes finos.

| Dado | Impacto |

|---|---|

| Compressão de contexto usando modelos dedicados | Melhora performance em agentes longos |

| Context window típico de LLMs | 8K a 32K tokens; compressão pode expandir esse limite virtualmente |

| Agentes ativos por mais de 24h | Relevância mantida graças à compressão de histórico |

Os Piores Tropeços: Casos Reais de Falha em Multi-Agent Systems

Quando comecei a explorar Multi-Agent Systems para Complex Task Solving com LLM Applications , parecia óbvio: dividir tarefas entre vários subagentes seria mais rápido e eficiente. Mas a realidade foi bem diferente. Tentar dividir tarefas que exigem nuances entre subagentes quase sempre dá ruim. Já vivi isso na pele — a promessa de colaboração de agentes se transformou num verdadeiro Frankenstein digital, com partes incompatíveis e resultados incoerentes.

Um exemplo clássico foi quando tentei construir um agente para criar um clone do Flappy Bird. Cada subagente ficou responsável por uma parte: um cuidava do pássaro, outro do fundo, outro da lógica do jogo. No final, o resultado parecia um patchwork: cada elemento tinha um estilo diferente, e o jogo simplesmente não fazia sentido. Isso aconteceu porque cada agente tinha sua própria visão do contexto, sem coordenação real.

Esse problema de contexto perdido é recorrente em Multi-Agent Systems. Mesmo frameworks avançados, como Agno ou AutoGen, enfrentam dificuldades sérias ao escalar o número de agentes. Quando tentei usar mais de três subagentes simultaneamente, o número de bugs triplicou. Além disso, notei que a redundância de tarefas aumentou o tempo de processamento em até 50%, e o desempenho caiu drasticamente em tarefas com mais de dois subagentes paralelos.

“Aprendi na prática: agente sem contexto compartilhado vira responsável por decisões conflitantes e perda de eficiência.” — Walden, Cognition

Essas falhas não são exclusivas dos meus experimentos. Relatos técnicos de 2024 já mostravam que modelos editando código com múltiplos agentes geravam resultados desastrosos. Muitas soluções evoluíram para sistemas single-threaded, como o modelo edit apply , justamente para evitar esse tipo de tropeço. O Claude Code, por exemplo, evita rodar múltiplos subagentes para além de perguntas pontuais. Quando precisa de subagentes, eles só respondem dúvidas específicas, nunca editam código em paralelo. Isso reduz drasticamente o risco de decisões desencontradas.

O grande desafio está na Colaboração de Agentes. Em teoria, a ideia de agentes especializados colaborando para resolver tarefas complexas é promissora. Na prática, a falta de um contexto compartilhado robusto torna o sistema frágil. Estudos recentes indicam que, mesmo em sistemas state-of-the-art , paralelismo mal implementado causa bugs e decisões inconsistentes. O problema não é só técnico, mas também de arquitetura: como garantir que cada agente tenha acesso ao histórico relevante para tomar decisões alinhadas?

Exemplos como Flappy Bird e Claude Code ilustram bem essas perdas de contexto. Sem coordenação real, os agentes acabam tomando decisões redundantes ou até conflitantes. Por isso, muitos especialistas defendem arquiteturas mais simples, com agentes single-threaded e contextos lineares, até que a tecnologia de passagem de contexto entre agentes evolua.

Refletindo sobre Colaboração Humano-IA: O que Agentes Ainda Não Aprenderam com a Gente

Quando falamos em Colaboração de Agentes usando LLM Applications, é quase inevitável comparar com a forma como nós, humanos, trabalhamos em equipe. Basta lembrar de uma situação comum: dois engenheiros discutindo um conflito de código. Eles conversam, negociam, ajustam, chegam a um consenso. Agora, tente imaginar duas IA fazendo isso com a mesma naturalidade. Não acontece — pelo menos, não ainda.

O grande desafio está na síntese e no compartilhamento de contexto. Nós, humanos, temos uma habilidade quase instintiva de identificar o que é importante numa conversa ou reunião. Conseguimos resumir, filtrar ruídos, e repassar só o essencial para o colega do lado. Já os agentes de IA, mesmo com toda a evolução das AI Development Tools e frameworks de Customização de Agentes, ainda tropeçam nessa etapa. Eles não conseguem, por exemplo, negociar decisões ou ajustar estratégias de forma proativa e eficiente.

Isso fica claro nos experimentos recentes. Desde 2022, estudos mostram que sistemas multi-agente raramente superam abordagens single-threaded na prática. O ganho de produtividade com agentes paralelos é, na melhor das hipóteses, marginal até 2025, segundo relatos técnicos. E, curiosamente, usuários relatam mais satisfação quando as decisões ficam centralizadas em um único agente, que consegue manter o fio da meada do contexto.

O motivo? Colaboração real exige compartilhar o que é importante. E isso ainda é um campo aberto para pesquisa e inovação. Como programar uma IA para entender o que deve ser compartilhado com outros agentes? Como garantir que cada agente tenha o contexto certo, sem sobrecarregar o sistema ou perder informações cruciais? Essas perguntas ainda não têm respostas simples.

Frameworks como Agno, OpenAI Swarm e AutoGen até oferecem ferramentas para criar e gerenciar sistemas multi-agente, mas a integração de contexto entre agentes permanece um ponto fraco. Muitas vezes, cada agente trabalha com pedaços isolados de informação, sem uma visão global — o que leva a decisões conflitantes ou resultados inconsistentes. É como se cada membro da equipe estivesse em uma sala diferente, sem saber o que o outro está fazendo.

Como diz Walden, da Cognition:

“Quando as IAs aprenderem a negociar contexto como uma equipe humana, teremos uma revolução. Até lá, vá de menos para mais.”

Olhando para frente, o desenvolvimento futuro dessas LLM Applications passa necessariamente pela humanização dos modos de colaboração entre agentes. Só assim será possível criar sistemas realmente eficientes, capazes de dialogar, negociar e construir soluções em conjunto — como já fazemos naturalmente em nossas equipes humanas.

Como Não Virar Refém do Hype: Princípios Básicos e Foco no Essencial

Quando comecei a explorar frameworks de agentes de IA, confesso que a tentação de seguir cada novo hype era enorme. Afinal, quem não quer experimentar a última novidade em AI Agent Frameworks ? Mas, com o tempo — e muitos erros — percebi que a busca incessante por soluções “mágicas” só trazia mais dores de cabeça do que resultados práticos.

O que realmente sustenta sistemas de IA robustos não é a quantidade de agentes rodando em paralelo, mas sim a Engenharia de Contexto em IA . Sem um contexto bem definido, até o modelo mais avançado se perde. Por isso, princípios sólidos como linearidade, histórico de decisões e clareza de contexto são essenciais. E, sinceramente, frameworks populares muitas vezes complicam mais do que ajudam. Eles prometem flexibilidade e paralelismo, mas entregam fragilidade e inconsistência — principalmente quando a comunicação entre agentes não é perfeita.

Na prática, vejo que menos é mais . Como disse Walden, da Cognition:

“O menos é mais dos agentes de IA: aposte nos fundamentos e você terá sistemas que realmente funcionam.”

A adoção de frameworks deve ser pragmática. Só faz sentido usar uma solução pronta quando ela resolve um problema real do seu domínio e, mesmo assim, é fundamental testar exaustivamente. Muitas das soluções inovadoras que desenvolvemos na Cognition surgiram justamente de tentativas frustradas de seguir o hype. Aprendemos que investir tempo nos princípios básicos reduz retrabalho e garante performance estável a longo prazo.

Dados internos mostram que 84% dos problemas em sistemas multi-agentes poderiam ser evitados com um fluxo single-threaded bem ajustado. O erro de arquitetura mais comum? Tentar paralelizar tarefas antes de garantir que a Engenharia de Contexto em IA está madura. Isso só reforça a importância de começar simples e evoluir conforme a necessidade real, não pelo modismo.

Hoje, quando penso em Customização de Agentes , foco primeiro em garantir que cada ação do agente esteja informada por todo o contexto relevante. Isso significa priorizar a continuidade do histórico e evitar decisões isoladas. Só depois, se o domínio exigir, considero expandir para arquiteturas mais complexas — sempre com cautela e muita validação.

Em resumo: ao invés de buscar o próximo grande framework de multi-agentes, foque nos fundamentos. A Engenharia de Contexto em IA é o que diferencia agentes confiáveis de experimentos frágeis. Frameworks são ferramentas, não atalhos. O segredo está em adaptar soluções ao seu contexto, sem se tornar refém do hype. Isso, sim, é construir IA de verdade.

TL;DR: No hype dos Multi-Agent LLMs, menos é mais. O segredo está em engenharia de contexto e princípios básicos, não em botar um exército de agentes pra conversar. Testei, falhou, aprendi, compartilho.

- Agentes de IA

- AI development

- Codificação

- Colaboração de Agentes

- Customização de Agentes

- Desenvolvimento

- Desenvolvimento Web

- Engenharia de Contexto em IA

- Ferramentas de Desenvolvimento de IA

- Frameworks de Agente de IA

- Git

- Grandes Modelos de Linguagem

- IA

- IA para Resolução de Tarefas Complexas

- Inovação

- LLM

- LLM Frameworks

- Multi-Agent LLMs

- pesquisa

- produtividade

- Sistemas Multi-Agentes

- Soluções

- Tecnologia

Autor

Posts relacionados

DSPy na prática: programação declarativa com LLMs

O DSPy transforma a forma como lidamos com prompts ao permitir a definição de assinaturas em Python para otimização automática de LLMs....

Quando programar vira prompt: o fim da era do código

A programação evoluiu com a IA, transformando-se de escrita manual de código para um processo de orquestração de prompts. Isso levanta questões...

Quando programar vira prompt: o fim da era do código

A programação evoluiu com a IA, transformando-se de escrita manual de código para um processo de orquestração de prompts. Isso levanta questões...

Como o Cursor transformou meu fluxo de desenvolvimento

O Cursor uniu editor, agentes e automações: planos rastreáveis (.cursor/plans/), Rules & Skills, cloud agents em cursor.com/agents, Debug Mode e comandos (/pr,...

A Revolução Silenciosa: Como a Anthropic e a Bun Estão Transformando o Desenvolvimento de Software com IA

Em 2025, a Anthropic consolidou sua estratégia de dominar a infraestrutura de desenvolvimento de software ao adquirir a Bun, uma startup com...

- Agentes de IA

- AI coding infrastructure

- AI software development

- Anthropic acquires Bun

- Anthropic market strategy

- Automação

- Bun JavaScript runtime

- Bun startup performance

- Claude Code

- Claude Code growth

- Codificação

- desenvolvedores

- Desenvolvimento

- desenvolvimento de software

- Generative AI trends

- Git

- IA

- Inovação

- Integração de IA

- Inteligência Artificial

- Inteligência artificial integrada

- Microsoft Nvidia investment

- OpenAI

- produtividade

- Software automation tools

- Soluções

- Tecnologia

- Tendências de IA

Como Usar Windsurf e Lovable para Criar Landing Pages que Convertem 100% GRÁTIS

Quero mostrar um fluxo prático e reproduzível para criar uma landing page de captura de leads que funcione de verdade, totalmente sem...

Leia tudo