LANGFLOW – O Flaw de Segurança Mais Idiota da IA: Uma Análise Profunda

Bem-vindo ao nosso mergulho profundo em um dos erros de segurança mais intrigantes que encontramos no mundo da inteligência artificial. Hoje, vamos explorar como a Langflow, uma plataforma de baixo código para construção de agentes de IA, permitiu que qualquer um executasse código Python arbitrário em seus servidores. Isso não é apenas uma falha teórica; foi uma execução remota de código (RCE) que foi explorada ativamente. Vamos entender como isso aconteceu e quais lições podemos aprender.

Sumário

- 🎨 O Cenário Inicial

- 🛠️ A Falha de Segurança

- 💡 A Teoria versus a Prática

- ⚠️ A Exploração Ativa

- 🤖 A Realidade da IA

- 🧠 As Lições a Aprender

- 🔍 FAQs

- 👨💻 Conclusão

🎨 O Cenário Inicial

Imagine que você está construindo uma startup. Você acaba de levantar dez milhões de dólares de um investidor que usa um colete da Patagonia, chamado Chad. Seu pitch deck mencionou “IA” quarenta e sete vezes e tinha uma foto do Iron Man, porque você está “destruindo inteligência”. Naturalmente, você integra o GPT ao seu aplicativo, adiciona alguns fluxogramas e, de repente, se torna uma plataforma de automação de IA para fluxos de trabalho de dados empresariais. Mas o que isso realmente significa?

É aqui que a Langflow entra em cena. Langflow é uma dessas ferramentas de baixo código que faz parecer que você está fazendo algo muito técnico, quando na verdade, você está apenas desenhando caixas coloridas que dizem “chamar OpenAI” e “consultar MongoDB”. Basicamente, é como uma ferramenta de script visual para construir agentes de IA. Arraste e solte para alcançar o modo deus.

🛠️ A Falha de Segurança

Agora, aqui está a parte que me fez rir alto. Eles tinham um endpoint, um endpoint de API exposto chamado /API v1/validate-code. Parece inofensivo, certo? Apenas uma pequena etapa de validação. Verifique se o código é legítimo, certifique-se de que você não está enviando um script que transforme seu servidor em um minerador de criptomoedas. Exceto que eles esqueceram uma coisinha. Ao validar o código Python enviado pelo usuário, você realmente não quer executar o código. E sim, foi exatamente isso que eles fizeram.

Esse endpoint aceitava código Python e, em seguida, o analisava e o avaliava no servidor sem qualquer isolamento, sem sanitização de entrada. Era como se estivessem executando código Python arbitrário diretamente no backend. O código da Langflow literalmente analisou a árvore de sintaxe abstrata (AST), aquela coisa que o Python usa para quebrar seu script em pedaços antes da execução. Depois, ele percorria as declarações de importação e definições de função para verificar se tudo correspondia à estrutura API esperada, porque a Langflow queria ter certeza de que o código funcionava bem com seu sistema de agentes.

💡 A Teoria versus a Prática

Isso parece inteligente, em teoria. Mas aqui é onde tudo sai dos trilhos. Em Python, definir uma função não apenas armazena a função. Se houver um decorador nessa função, aquele pequeno @algo acima do def, ele é executado imediatamente durante a definição. Portanto, um hacker malicioso pode simplesmente escrever algo como end lang flow em sua nobre busca para validar o código. O resultado? A definição da função é avaliada e, boom, o decorador é executado, a carga útil é entregue, e o hacker está dentro.

Não é necessário nem chamar a função. Foi assim que a Horizon3.ai encontrou a vulnerabilidade. Eles enviaram um script com um decorador malicioso, conseguiram execução remota de código (RCE) e acessaram um shell no backend. E o pior? Eles descobriram que, embora o contêiner mostrasse que o usuário não era root, o ID do grupo era root. E sim, isso ainda é muito, muito ruim. O acesso ao nível do grupo ainda pode ser suficiente para bagunçar coisas como /etc, memória compartilhada, logs, processos, todas essas coisas divertidas.

⚠️ A Exploração Ativa

E isso não foi um ataque teórico que poderia ter sido feito. Isso estava acontecendo na vida real. A CISA emitiu um alerta. Hackers reais estavam explorando isso. A Langflow corrigiu na versão 1.0.0, crédito onde é devido. Mas, honestamente, a correção foi apenas eles finalmente isolando o código e garantindo que ele não executasse decoradores durante a validação, o que é, novamente, algo que eu deveria ter feito desde o dia zero.

Se você já construiu algum tipo de sistema onde os usuários podem enviar código, mesmo um CTF, um juiz de código, um playground, qualquer coisa, você sabe que a primeira regra é nunca executar código não confiável diretamente, nem na sua máquina, nem mesmo no Raspberry Pi do seu primo. Você isola, coloca em um contêiner Docker, enfia em um cárcere, queima em um fogo. É isso que se deve fazer.

🤖 A Realidade da IA

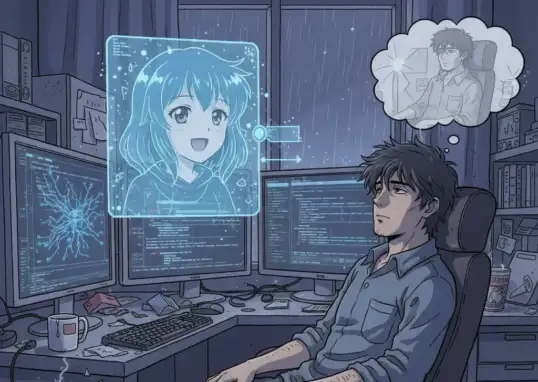

A parte mais louca, apenas olhando para o código de validação da Langflow. Sabe, como a formatação real, o espaçamento de comentários esquisitos, a indentação chunky. Parece gerado por IA. Isso é o que quero dizer quando digo que a IA não é o problema. Mas jogar IA em tudo sem entender o que está fazendo é absolutamente um problema. Você não pode ter IA escrevendo metade do seu backend e depois se surpreender quando ela esquece a segurança 101, como não executar código estranho diretamente em produção. Isso nem é segurança 101. É senso comum.

Imagine que estou realizando uma cirurgia, mas toda a operação é liderada por um assistente de IA que diz para inserir um escalpelo no socket ocular. Se eu seguir isso cegamente porque o modelo sabe melhor, não é culpa da IA. É minha por confiar nela sem verificar os cálculos. Isso está acontecendo aqui. A IA está sendo tratada como uma espécie de oráculo mágico que não precisa de supervisão, e isso é um problema.

Turbine seu Desenvolvimento com Prompts!

Você já sonhou em criar seu próprio aplicativo mas pensou que precisaria ser um gênio da programação? Chegou a hora de transformar esse sonho em realidade! Com as ferramentas no-code de hoje, você pode criar aplicativos profissionais sem escrever uma única linha de código.

🧠 As Lições a Aprender

Então, qual é a lição aqui? Se você está construindo uma ferramenta de IA, ótimo. Faça isso. É legal. Mas, por favor, pelo amor de acesso root, tenha certeza de que há um humano que realmente entende o que está acontecendo nos bastidores. Você não pode automatizar sua maneira de sair da responsabilidade. E se você é um hacker assistindo isso, sempre, sempre verifique como as ferramentas de IA lidam com a entrada de código, porque noventa por cento dessas startups estão correndo para o MVP e pulando a parte onde eles garantem a segurança de seus endpoints.

E se você souber como ativar peculiaridades do Python, como decoradores durante a análise da AST, você já está dois passos à frente. De qualquer forma, vá corrigir suas coisas. Vá construir coisas legais e vá conferir o Langflow v1.0.0 se você estiver curioso. Mas, talvez, não faça upload de nenhum decorador. Certo?

🔍 FAQs

O que é Langflow?

Langflow é uma plataforma de baixo código para a construção de agentes de IA, permitindo que desenvolvedores criem aplicações de forma visual e intuitiva.

Qual foi a falha de segurança encontrada na Langflow?

A falha permitiu a execução remota de código (RCE) devido à validação inadequada de código Python enviado pelo usuário, que era executado no servidor sem a devida segurança.

Como a Horizon3.ai descobriu a vulnerabilidade?

Horizon3.ai encontrou a vulnerabilidade ao enviar um script com um decorador malicioso que foi avaliado e executado no servidor da Langflow.

Qual é a lição mais importante sobre segurança em IA?

A lição é que você deve sempre validar e isolar o código não confiável. Nunca execute código enviado por usuários sem a devida segurança.

O que devo fazer se eu souber sobre uma falha de segurança?

Se você souber sobre uma falha, é essencial reportá-la ao desenvolvedor do software e, se possível, aplicar uma correção temporária até que uma solução permanente seja implementada.

👨💻 Conclusão

O ecossistema de IA é emocionante e cheio de oportunidades, mas também vem com suas armadilhas. No caso da Langflow, a falta de atenção à segurança resultou em uma falha que poderia ter sido facilmente evitada. Como desenvolvedores e usuários de IA, devemos sempre estar vigilantes e garantir que a segurança seja uma prioridade em todos os níveis de desenvolvimento. Este é um lembrete de que, embora a tecnologia avance rapidamente, a responsabilidade e a compreensão fundamental do que estamos construindo não podem ser deixadas de lado.

Se você gostou deste mergulho caótico em segurança de IA, não esqueça de compartilhar e se inscrever para mais análises e insights. E lembre-se, a segurança começa com conhecimento e atenção. Paz!

Autor

flpchapola@hotmail.com

Posts relacionados

DSPy na prática: programação declarativa com LLMs

O DSPy transforma a forma como lidamos com prompts ao permitir a definição de assinaturas em Python para otimização automática de LLMs....

Quando programar vira prompt: o fim da era do código

A programação evoluiu com a IA, transformando-se de escrita manual de código para um processo de orquestração de prompts. Isso levanta questões...

Quando programar vira prompt: o fim da era do código

A programação evoluiu com a IA, transformando-se de escrita manual de código para um processo de orquestração de prompts. Isso levanta questões...

Como o Cursor transformou meu fluxo de desenvolvimento

O Cursor uniu editor, agentes e automações: planos rastreáveis (.cursor/plans/), Rules & Skills, cloud agents em cursor.com/agents, Debug Mode e comandos (/pr,...

A Revolução Silenciosa: Como a Anthropic e a Bun Estão Transformando o Desenvolvimento de Software com IA

Em 2025, a Anthropic consolidou sua estratégia de dominar a infraestrutura de desenvolvimento de software ao adquirir a Bun, uma startup com...

- Agentes de IA

- AI coding infrastructure

- AI software development

- Anthropic acquires Bun

- Anthropic market strategy

- Automação

- Bun JavaScript runtime

- Bun startup performance

- Claude Code

- Claude Code growth

- Codificação

- desenvolvedores

- Desenvolvimento

- desenvolvimento de software

- Generative AI trends

- Git

- IA

- Inovação

- Integração de IA

- Inteligência Artificial

- Inteligência artificial integrada

- Microsoft Nvidia investment

- OpenAI

- produtividade

- Software automation tools

- Soluções

- Tecnologia

- Tendências de IA

Como Usar Windsurf e Lovable para Criar Landing Pages que Convertem 100% GRÁTIS

Quero mostrar um fluxo prático e reproduzível para criar uma landing page de captura de leads que funcione de verdade, totalmente sem...

Leia tudo